理数工学科 No.22 鈴木健心

①研究の背景

昨今、日常生活で合成音声を耳にする機会が増えた。

たとえば赤電のアナウンスの一部は合成音声である。

合成音声は比較的低コストで聞き取りやすい音声を瞬時に作成できるため、今後一層耳にすることは多くなるだろう。

②仮説とねらい

合成音声で感情が欠落する原因を考えた。

私たち人間が読み上げた文章を、合成音声にすることを考えてみる。

この場合以下のようなプロセスを辿ることになる。

人間が文章を考える段階では感情はある。

しかし文章にした段階で私たちの声が持つ、微妙な感情は全て失われてしまう。

そこで私は次のような仮説を立てることにした。

仮説①

コンピュータができないのは感情を表現することではなく、感情を読み取ることである。

これはつまり、コンピュータは文章から感情を読み取ってそれを表現することができないということだ。

言い換えれば感情を読み取らせなければコンピュータは感情を表現できるというのがこの仮説の本質といえる。

今回の研究では感情のある人間の声をディープラーニングを用いて、感情を持ったまま別の声に変換することを目的とすることにする。

③研究内容

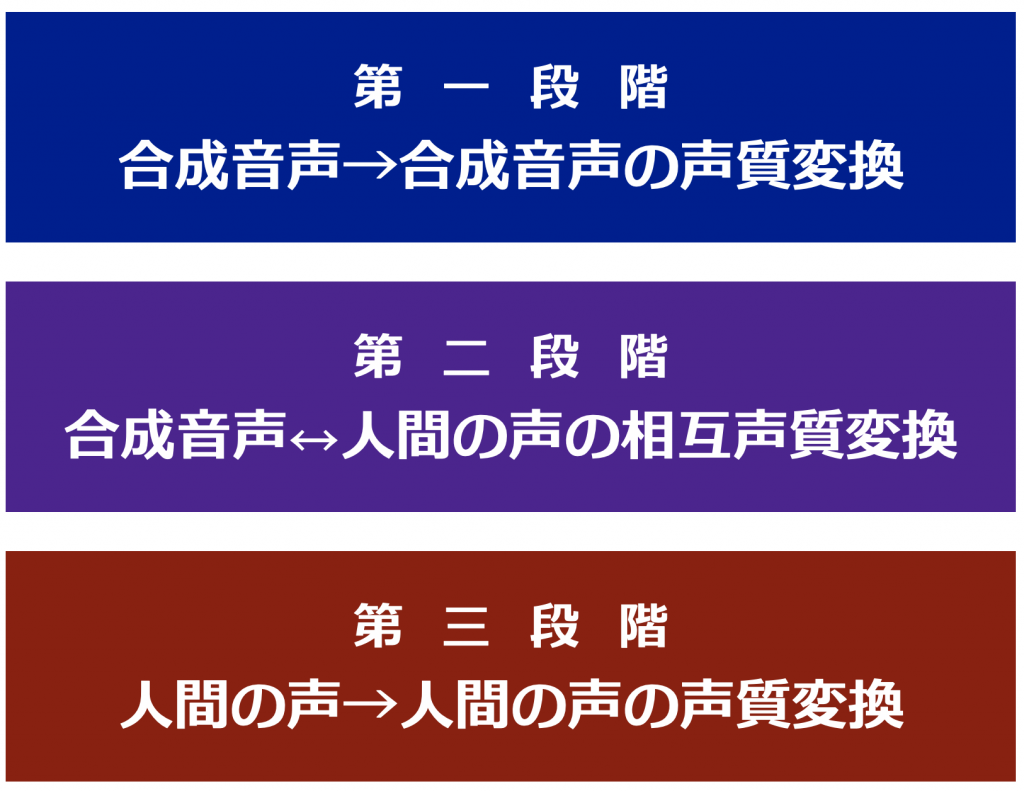

研究は以下の通り三段階に分けて進行する。

音声の変換

ディープラーニングで声を変換するには、声の特徴を数値として表す必要がある。

そこでメル-ケプストラムを用いることにした。

学習は変換元の声と変換先の声で、同じ文章をなるべく同じ速度、同じタイミングで発音させる。

そしてそれをメル-ケプストラムに変換をして、ディープラーニングにかける。

第一段階 ( 合成音声→合成音声の声質変換 )

この段階では2つの合成音声ソフトを使って用意した2つの音声データを使って学習をさせた。

④技術的知識

言語はpython3を使用した。

CPUでディープラーニングを行うと非常に長い時間がかかるため、CUDAを使ってGPUによる並列化を試みた。

CUDAを用いると、計算を同時にたくさん計算させることができるため、高速にディープラーニングをさせることができる。

⑤これからの取組

デバイス的要因で第二・第三段階を実験できなかったのでノイズの少ないマイクを用意できたら第一段階と同じように試行したい。

⑥まとめ

技術をより多くの人がより簡単により不快感なく使えること目指してこの研究を行ったが、それが達成できる道筋が見えるところまで進めることができてうれしく思う。